Recibido: 19 de noviembre de 2019; : 17 de junio de 2020; Aceptado: 24 de junio de 2020

Homogeneidad y heterogeneidad en los resultados de dos instrumentos de evaluación de políticas públicas

Homogeneity and Heterogeneity in the Results of Two Public Policy Evaluation Instruments

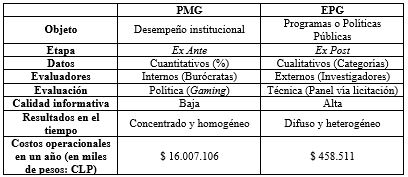

La evaluación de políticas públicas constituye una etapa fundamental de transparencia y accountability dentro del ciclo de políticas públicas. El artículo analiza el comportamiento de dos instrumentos de evaluación de gestión y políticas públicas del servicio civil chileno en las últimas décadas: el Programa de Mejoramiento de Gestión (PMG) y la Evaluación de Programas Gubernamentales (EPG). Para eso se utilizaron datos de informes oficiales e informaciones disponibles en el sitio web de la Dirección de Presupuestos (DIPRES). La investigación expone los resultados utilizando estadística descriptiva y temporal. Con relación a los hallazgos, los instrumentos de PMG mostraron un patrón concentrado y homogéneo en los últimos dieciséis años analizados, con un porcentaje temporal promedio de logro por ministerio que se posiciona por sobre el 95%. El EPG, por su parte, presentó un patrón difuso y heterogéneo en las últimas dos décadas, con alta oscilación, pero con un promedio en el tiempo entre baja y media calidad en los programas de políticas públicas evaluados.

Palabras clave

Evaluación, Evaluación de Políticas, Evaluación de Programas, Política Pública, Indicadores Administrativos, Estudio de Casos, Chile.Resumen, traducido

The evaluation of public policies is a fundamental stage of transparency and accountability within the public policy cycle. This paper analyzes the behavior of two Chilean civil service evaluation instruments of management and public policy in the recent decades: the Management Improvement Program (PMG) and the Evaluation of Government Programs (EPG). Data from official reports and information available on the website of the Budget Office (DIPRES) were used for this purpose. The research uses temporal and descriptive statistics to show its results. The PMG instruments showed a concentrated and homogeneous pattern in the last 16 years, with a temporary average percentage of achievement by ministry that is positioned above 95%. On the other hand, the EPG presented a diffuse and heterogeneous pattern in the last two decades, with high oscillation, but with a time average between low and medium quality in the evaluated public policy programs.

Keywords

Evaluation, Policies Evaluation, Programs Evaluation, Public Policy, Administrative Indicators, Case Analysis, Chile.Introducción

Esta investigación busca analizar dos instrumentos de evaluación de gestión y políticas públicas del servicio civil chileno en un intervalo de dieciséis y veinte años: el Programa de Mejoramiento de Gestión (PMG) y la Evaluación de Programas Gubernamentales (EPG), respectivamente. Así, se presentan sus indicadores empíricos y temporales con el objetivo de observar cómo se comportan los resultados de esas herramientas en ese periodo. Como las investigaciones sobre evaluaciones gubernamentales de políticas públicas son escasas en la literatura, este estudio ofrece su contribución, relacionando esos sistemas que se conectan directa e indirectamente en el marco de la Nueva Gestión

Pública (NGP) chilena y su ciclo presupuestario. La evaluación también tiene central importancia en el ciclo de políticas públicas, siendo la etapa que permite el control de los resultados de la gestión, otorgando transparencia y contribuyendo a la accountability sobre los resultados de las políticas públicas producidas.

Los objetos, propósitos, evaluadores y etapas de operación, producen lógicas propias que se muestran bastante diferentes en esos dos instrumentos de evaluación institucional. El PMG se constituye en metas asociadas al desempeño institucional y que se traduce en bonos por el cumplimiento de esos objetivos, sus evaluadores son internos -compuestos por miembros de la propia institución o gobierno- y la definición de los indicadores y metas se establece en el proceso de evaluación ex ante o previa a la acción gubernamental. Los resultados de esta investigación muestran que los datos temporales del PMG han aumentado su concentración en el tiempo y el promedio entre instituciones también ha presentado alta homogeneidad: el logro por ministerio se posiciona, en promedio, por sobre el 95% de cumplimiento en los dieciséis años analizados.

En distinto sentido, la evaluación hecha por expertos externos al sector público que caracteriza a la evaluación cualitativa del EPG, muestra un comportamiento empírico y temporal difuso y heterogéneo en las últimas dos décadas. El EPG tiene como objetivo evaluar los resultados de servicios y políticas públicas de determinados programas y que se puede traducir en aumento o disminución del presupuesto dirigido al programa en cuestión, sus evaluadores son independientes o externos a las burocracias analizadas, y es implementado en el marco de la evaluación ex post -realizada una vez finalizada la intervención del gobierno o gestión de un determinado periodo-, involucrando análisis de resultados inmediatos, intermedios o finales (CEPAL, 2003: 14-15). Los resultados de los EPG oscilan mucho en el tiempo pero están ubicados, en promedio, entre desempeños bajos y medios, y son pocos los casos de buen desempeño.

En resumen, el artículo reitera primera y principalmente, la concentración y homogeneidad en los resultados de los indicadores de PMG en contraste con los resultados difusos y heterogéneos de las evaluaciones EPG. En segundo lugar y consecuentemente, da cuenta tanto de las idiosincrasias cualitativas del EPG, como el bajo poder informativo del PMG, que adviene de práctica de gaming en la construcción de ese indicador (Zaviezo ...[et al], 2016). Considerando que las metas de PMG están asociadas a incrementos del sueldo de los burócratas, se verifica la entrega sistemática de bonificaciones totales en los dieciséis años analizados -los casos que representan la disminución de pago del incentivo, o la ausencia de pago, son escasos y desviantes. Los autores apuntan que los bonos del PMG se han constituido más como parte del sueldo de los funcionarios públicos (también llamado de aguinaldo en Chile) que un instrumento de incentivo al cumplimiento efectivo de metas de gestión.

Por último, y así como señala la OCDE, se confirma la existencia de desconexiones en ese amplio sistema de evaluación. De un lado, aunque el PMG y EPG tengan conexión con el sistema presupuestario, no poseen formalmente impactos en el gasto público nacional (DIPRES, 2019b: 120). De otro, está la baja asociación entre evaluaciones ex ante y ex post (idem), lo que parece ser el caso cuando se miran las características y los resultados de los dos instrumentos analizados.

Material y método

Como estrategia de investigación, para los PMG, se tomaron los porcentajes totales del logro según ministerio[1], por año, presentes en distintos informes de la Dirección de Presupuestos (DIPRES). Se utilizaron las Estadísticas de gestión pública 2001-2015 (DIPRES, 2015) para ese intervalo, y para los años siguientes: las Estadísticas de gestión pública 2006-2016 (DIPRES, 2017), los Resultados del Programa de Mejoramiento de la Gestión de 2017 (DIPRES, 2018) y los Resultados de Evaluación PMG de 2018 (DIPRES, 2019). Ante la inexistencia de datos para los primeros dos años (2001 y 2002) en las series temporales, se inició el análisis del PMG al año de 2003. Con eso se llegó a un total de 322 observaciones en esos dieciséis años (2003-2018) para 22 instituciones del poder ejecutivo[2].

Para los EPG se obtuvieron los datos directamente del sitio web de la Dirección de Presupuestos (DIPRES, 2019c), disponibles desde 1997 hasta 2019, en el que constan: el año de protocolo, el programa o institución, la línea de evaluación, el ministerio, el servicio público y la clasificación de DIPRES para el programa o política pública evaluada. Se utilizó en específico y solamente la línea de investigación fijada para EPG -el ministerio- agregando los respectivos programas evaluados y, con base en las clasificaciones ofrecidas por DIPRES, se agregaron en nuevas categorías ordinales para fines analíticos. Como no hay datos para los años de 1997, 1998 y 1999 se inició el análisis del EPG en el año 2000 y, por lo tanto, se lograron 334 observaciones en esos veinte años (2000-2019) para 24 instituciones[3].

Se aplicó estadística descriptiva para analizar los datos y se los presentaron por ministerio y/o en el tiempo, utilizando el software Stata 15. Para las ilustraciones, se incorporaron gráficos de barra, boxplots, y también eventual empleo de estadística descriptiva temporal.

Resultados y discusión

Las dos herramientas de evaluación son productos de la incorporación de procesos modernizadores de la NGP en Chile (Figueroa, Olavarría y Navarrete, 2011) entre los que se incluye la gestión pública por resultados (CEPAL, 2003). En esta se señala que la evaluación de la gestión es la “medición sistemática y continua en el tiempo de los resultados obtenidos por las instituciones públicas y la comparación de dichos resultados con aquellos deseados o planeados, con miras a mejorar los estándares de desempeño de la institución” (OCDE, 1998).

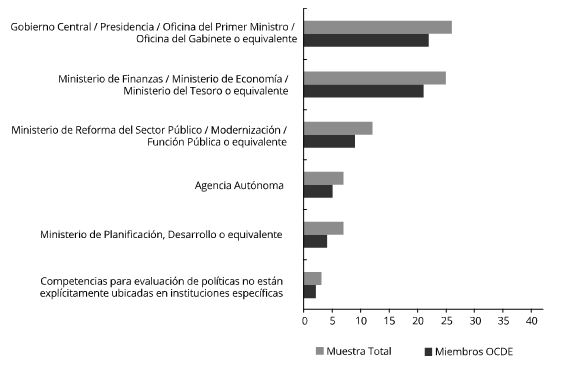

Los avances de Chile logrados en su primera década de operación posicionaron al país como un ejemplo a nivel mundial en materia de sistemas de monitoreo y evaluación, junto a otros países con mayor nivel de desarrollo económico de la OCDE (Darville, Rogers y Guzmán, 2019). Entre los miembros de esa organización se aprecia (ver Figura 1) que las competencias dentro del poder ejecutivo para la evaluación de políticas están en su mayoría en el centro del gobierno o en el ministerio de finanzas/economía, siendo este último el caso chileno.

Figura 1

Más específicamente, el sistema de evaluación chileno se concentra en el Ministerio de Hacienda, centralizándose exclusivamente en la Dirección de Presupuestos (DIPRES). El Ministerio de Hacienda ha desarrollado un conjunto de iniciativas con el objetivo de mejorar la información sobre la gestión de los servicios públicos y sus resultados, transparentando su uso. Adscribiéndose al concepto de Presupuesto por Resultados, utilizado por los países de la OCDE, y bajo la categoría de “Presupuesto Informado”, se diseñó e implementó un “Sistema de Evaluación y Control de Gestión del Gobierno Central” con el objetivo de generar información de desempeño e introducir prácticas para mejorar la calidad del gasto. Dicho sistema se ha ido conformando por diversos instrumentos desarrollados desde 1993 en adelante, asociados a los procesos de formulación, monitoreo o seguimiento, evaluación y provisión de incentivos de remuneraciones en el sector público.

En la literatura de ciencia política y administración pública de los últimos años es posible observar investigaciones con resultados más optimistas, bajo la herencia de la NGP, para los avances en eficiencia y gestión de políticas públicas en Chile (Lira, 2013; Morales, 2014; Cortázar ...[et al], 2016). Otras, menos optimistas, mencionan problemas en actores y procesos en el modus operandi más flexible y político de su funcionamiento institucional (Schuster ...[et al], 2017; Fuenzalida y Riccucci, 2018). En relación con los estudios que miran en específico las evaluaciones de políticas públicas, cuando Zaviezo ...[et al] (2016) analizan el PMG, destacan posibles prácticas de gaming en los procesos de construcción de esos indicadores por parte de los actores gubernamentales, lo que significa que estos crean estrategias para no poner en riesgo la retribución esperada (idem). Eso ha ocurrido especialmente, porque existen incentivos monetarios que se asocian a la construcción de los indicadores del instrumento PMG, siendo 100% del beneficio pagado solamente cuando el resultado esté por encima del 90% de cumplimiento de la meta comprometida, traduciéndose en cuatros sueldos o más al año.

Para fines de ilustración de los impactos de esa práctica, se efectuó una estimativa bajo un único dato de 2006 que fue posible encontrar, por la cual el Estado chileno gastó en el PMG tanto con el incentivo como con los gastos fijos en ese año (DIPRES, 2008: 16). Para asumir una postura aún más conservadora, se calculó el pago del incentivo proporcional solamente al porcentaje de las instituciones que recibieron 100% del beneficio por bono de desempeño (DIPRES, 2019), y se mantuvieron los otros gastos fijos constantes -personal, bienes y servicios, capacitación, certificación y evaluadores externos. Con eso y sin considerar la inflación, el valor gastado por los cofres públicos para el PMG alcanzó un promedio de CLP 612.517.162 miles de pesos, en el período de dieciséis años, o CLP 38.282.322 miles de pesos por año -siendo CLP 22.275.216 miles de pesos pagados solamente en incentivos promedios por año, resultado proporcional y solamente estimado para aquellos que recibieron el 100% en ese intervalo- y unos CLP 16.007.106 miles de pesos anuales con gastos operacionales. Aunque esa estimativa sea subvalorada, el gasto público del PMG se muestra substantivo, involucrando por lo tanto altos montos invertidos en los incentivos y costos operacionales de la máquina pública.

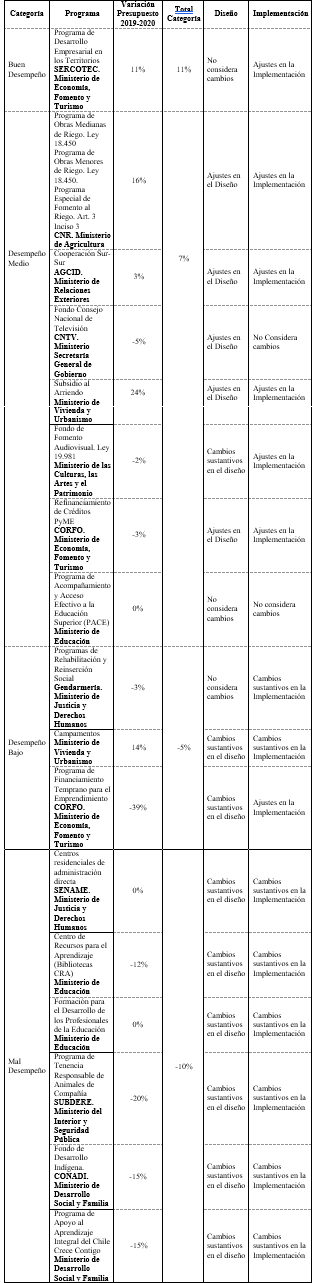

El caso del EGP es diferente, pues los resultados de sus evaluaciones parecen tener alguna relación con la variación presupuestaria reciente. Eso porque el proyecto de Ley de Presupuestos ha contemplado un aumento de un 2% del presupuesto asignado para los programas con evaluaciones finalizadas durante el segundo trimestre de 2019. Sin embargo y tal como se muestra en el Cuadro 1, existe una heterogeneidad en las variaciones entre 2019 y 2020 para el grupo de programas presentados específicamente en el referido informe. En la columna de lo total por categoría, se notan aumentos de 11% y 7% de recursos para los programas de buen y medio desempeño, mientras bajo y mal desempeño tuvieron una disminución en la casa de 5% y 10% (DIPRES, 2019b: 111).

Cuadro 1

En un estudio reciente de la OCDE, la organización ha destacado los logros y limitaciones del estado actual del sistema de evaluación de políticas públicas en Chile, a los cuales se incluyen balances y recomendaciones, como: (i) hay mucho énfasis en las evaluaciones ex post; (ii) existe una falta de conexión entre las evaluaciones ex ante y ex post; (iii) hay una ausencia de mecanismos formales para considerar los resultados en el proceso presupuestario -así los actores involucrados perciben que hay más contribuciones de las evaluaciones para el diseño y administración de los programas que en la asignación más eficiente de recursos-; (iv) igual no es claro el mecanismo que relaciona las evaluaciones al gasto presupuestario -en pocos casos los programas aparecen identificados, muchas veces están ocultos o dentro de un subtítulo o asignación presupuestaria, lo que dificulta el seguimiento del gasto o evaluación de eficiencia y efectividad del programa-; (v) la cobertura anual de las evaluaciones es baja -no supera el 5% del presupuesto total-; y, (vi) las unidades de evaluaciones son limitadas -enfocando en programas específicos en vez de áreas de políticas públicas o metas gubernamentales (OCDE Survey on Policy Evaluation 2018 Apud DIPRES, 2019b: 119-121). En comparación con otros países de la OCDE, en Chile, los otros ministerios sectoriales, el congreso, y otros actores políticos relevantes, desempeñan un rol inexistente o limitado en el proceso de evaluación (idem: 129), aspecto que parece influenciar la debilidad de los mecanismos institucionales, tal cual la relación entre las evaluaciones y las leyes presupuestarias nacionales.

A continuación se presentan las características de cada una de estas herramientas y sus resultados en el tiempo. En el caso de los PMG se utilizaron datos sistemáticos de los respectivos ministerios para el periodo de los dieciséis años analizados. En el caso de los resultados de la evaluación EPG, se agregaron los resultados de los programas y políticas públicas evaluadas por ministerio, en un intervalo de veinte años investigados.

Programa de Mejoramiento de Gestión (PMG): concentrado y homogéneo

Las iniciativas impulsadas por la DIPRES han estado enfocadas en introducir nuevos mecanismos de evaluación y perfeccionar los instrumentos ya vigentes (Marcel …[et al], 2001; CEPAL, 2003). Para eso, DIPRES ha contemplado el Programa de Mejoramiento de Gestión (PMG) que cubre las instituciones públicas e incluye la identificación y elaboración de indicadores asociados a los principales productos (bienes o servicios) y el desarrollo de adecuados sistemas de recolección y sistematización de información.

A contar del año 2008 el Sistema de Evaluación y Control de Gestión del Gobierno Central ha estado a cargo de la DIPRES, y desde el año 2012 también del Ministerio de Desarrollo Social (MDS), dado que la Ley N° 20.530 establece que este último debe evaluar y pronunciarse mediante un informe de recomendación sobre los programas sociales nuevos o que planteen reformularse. De esta manera, la evaluación ex ante inicia con el ciclo presupuestario y tiene como finalidad contar con un conjunto de programas con diseños adecuados y validados técnicamente, para recibir financiamiento vía Ley de Presupuesto. Por lo tanto, la DIPRES y el MDS deben trabajar coordinadamente, acompañando técnicamente a los programas tanto no sociales como sociales, respectivamente (Darville …[et al], 2019).

En este proceso, denominado Ciclo Presupuestario, además de entregar información relativa a la formulación estratégica y lógica de los programas públicos a través de formatos estándar, los servicios públicos deben presentar los indicadores y metas derivadas de los objetivos establecidos en la planificación, efectuada en el proceso de evaluación ex ante, vía PMG, y sus indicadores son utilizados para el pago de bono por incentivos monetarios. Con relación a esos incentivos, ellos poseen tres componentes: uno fijo correspondiente a un 15% de una base de remuneraciones definida en la ley, uno variable colectivo correspondiente a un 8%, y uno variable institucional correspondiente a un 7,6%, todos calculados sobre la remuneración base anual (DIPRES, 2018: 5).

Eso significa que cuatro veces al año -trimestralmente- los funcionarios públicos[5] reciben un bono equivalente al doble del sueldo recibido en los meses en los que no corresponde el pago del incentivo, considerando en dicho monto, el 8% del componente variable colectivo por el cumplimiento de metas -comprometidas entre el Ministro del ramo y Jefe Superior de Servicio. Este último es considerado un incentivo “descentralizado dado que se organiza por grupos o unidades de trabajo y no es evaluado por externos al sector público, sino por las unidades de auditoría interna del ministerio respectivo” (idem). Por otra parte, el componente variable institucional se caracteriza por ser centralizado porque un Comité Triministerial, compuesto por los Ministros de Hacienda, Interior y Seguridad Pública y Secretario General de la Presidencia define los lineamientos estratégicos comunes a todos los Servicios Públicos evaluados también por externos al sector público. Este incentivo corresponde al 7,6% de la remuneración base anual y es pagado solo si la institución alcanza un grado de cumplimiento anual igual o superior al 90% de los objetivos comprometidos. En caso de alcanzar un cumplimiento inferior al 90% e igual o superior al 75%, el incentivo corresponde solo al 3,8% de la remuneración base anual, y si dicho cumplimiento es menor al 75% el incentivo corresponderá a un 0% (DIPRES, 2018: 6).

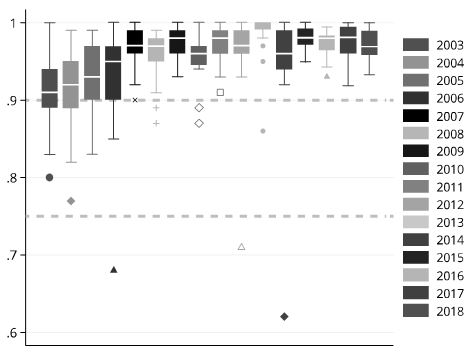

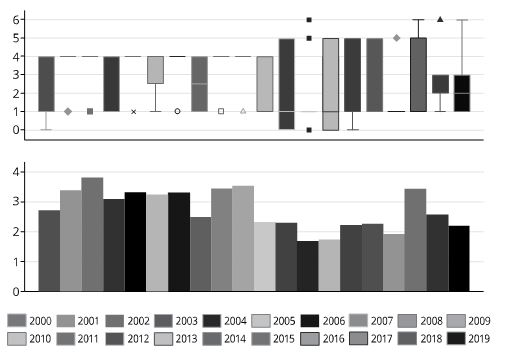

Estudios anteriores han manifestado la existencia de la práctica de gaming vía la manipulación de los indicadores, las metas, o los resultados, con el propósito de facilitar la obtención de los bonos de PMG (Zaviezo …[et al], 2016: 6). Esta investigación confirmó ese elemento, pues los indicadores se mantienen sistemáticamente y con concentración creciente por sobre el 90% de cumplimiento. Para visualizar mejor ese patrón, se incorporó una primera línea con guion horizontal, en los boxplots abajo -las cajas representan el 50% de los valores. Se puede observar que los primeros años, desde 2003 hasta 2006, el PMG se encontraba aún en contacto con el tramo de 90% y con extensiones para bajo. A su vez sus respectivas medianas ya subían anualmente en ese intervalo y, en el año de 2007, se evidencia un cambio importante cuyas extensiones se ubicaron por sobre el 90% de cumplimiento y la caja muy sistemáticamente cerca del 100%. En el segundo tramo de pago de beneficio, se presenta una segunda línea con guion horizontal en el marco de un 75%, que muestra como son pocos los casos que pertenecen entre ese nivel y el 90%, siendo aún más escasas las observaciones que estén debajo del 75% -y que inviabiliza el pago del incentivo.

Figura 2

A continuación se incorporaron líneas con guion en la vertical para establecer los años del ciclo electoral presidencial. La concentración sigue evidente y se nota que de hecho empieza de modo más substancial post 2006, ubicándose especialmente en el tramo sobre el 90% de cumplimiento, con disminución de la variación, a excepción de un par de casos desviantes. Entre estos y abajo del 75%, es factible notar que el primero pertenece a la Presidencia exactamente en 2006 y los otros dos al Ministerio de Medio Ambiente al año 2012 y 2014, es decir, de esos tres outliers, dos pasaron en años electorales y fueron las únicas observaciones que inviabilizaron los pagos de los incentivos a los funcionarios de esas burocracias en esos años.

Figura 3

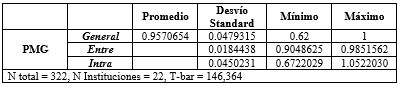

Esa concentración serial es confirmada por un promedio temporal que alcanza un 95,7% en el intervalo analizado, presentando también un bajo desvío estándar de 4,7%. Cuando se observa el comportamiento inter e intrainstitucional, ese patrón permanece. El desvío estándar intrainstitucional es equivalentemente bajo, siendo una oscilación promedio de 4,5% por ministerio y en el tiempo -muy influenciados por los casos desviantes de la Presidencia y del Ministerio del Medio Ambiente. Para las diferencias entre las instituciones la variación se muestra aún más baja, presentando un 1,8% de diferencia temporal entre las burocracias del poder ejecutivo, lo que confirma también una alta homogeneidad de esos indicadores, comparativamente.

Tabla 1

Evaluación de Programas Gubernamentales (EPG): difuso y heterogéneo

La Evaluación de Programas Gubernamentales (EPG), también a cargo de la DIPRES, surge a partir del año 1997 con el objetivo de “disponer de información que apoye la gestión de los programas públicos y el análisis de resultados en el proceso de asignación de recursos públicos”[6]. El EPG ha utilizado desde sus inicios la metodología de Marco Lógico (Ortegón, Pacheco y Prieto, 2005) para analizar e identificar oportunamente problemas de diseño e igual identificar, y luego cuantificar, los principales indicadores que dan cuenta de su desempeño en los distintos niveles de objetivos, en particular a nivel de propósito y producto (componentes)[7].

Esa evaluación considera, al menos, los siguientes focos o ámbitos: (i) la justificación -el diagnóstico o problema que dio origen al programa y que este espera resolver (o contribuir a solucionar)-; (ii) el diseño -análisis del ordenamiento y consistencia del programa considerando sus definiciones de fin y propósito (objetivos), sus componentes y actividades para responder a ellos y los supuestos bajo los cuales se elaboraron las hipótesis del programa-; (iii) la organización y gestión -análisis de los principales aspectos institucionales dentro de los cuales opera el programa, y de los principales procesos, instancias de coordinación e instrumentos de que este dispone para desarrollar sus actividades y cumplir su propósito-; y (iv) los resultados -el análisis se centra en la evaluación de la eficacia, eficiencia y economía del programa (idem). Sobre la base del análisis del diseño, organización y gestión, y resultados o desempeño del programa, la evaluación también incorpora un juicio respecto de la sostenibilidad del programa en términos de capacidades institucionales, su continuidad, considerando la evolución del diagnóstico inicial y un conjunto de recomendaciones para corregir problemas detectados y/o mejorar sus resultados (ibidem).

En el desarrollo de las EPG participa un Comité Interministerial conformado por un representante del Ministerio Secretaría General de la Presidencia, del Ministerio de Desarrollo Social y del Ministerio de Hacienda a través de la DIPRES, siendo presidido por el representante de esta última cartera. Este Comité tiene entre sus funciones velar por el correcto desarrollo de las evaluaciones, especialmente en los procesos de selección de programas y selección de consultores.

Las evaluaciones son realizadas por paneles evaluadores constituidos generalmente por tres profesionales externos al sector público, quienes tienen la responsabilidad de efectuar las evaluaciones de acuerdo con los procedimientos definidos por el Ministerio de Hacienda. La selección de los evaluadores se realiza cada año a partir de una convocatoria pública que aplica criterios y análisis técnico en ese proceso, la que se incorpora en el Sistema de Información para la selección de consultores de EPG. El proceso de selección considera básicamente las competencias de los profesionales en el área de evaluación y en el área de intervención del programa. Adicionalmente, para la conformación de los paneles de evaluación, se utiliza como criterio de selección la complementariedad de especializaciones entre los profesionales que postulen a integrar los distintos paneles[8].

Las instituciones responsables de los programas evaluados se incorporan al proceso de evaluación a través de las actividades de: (i) entrega de información, (ii) elaboración de matriz de marco lógico preliminar, (iii) participación en reuniones que soliciten el panel evaluador y el Ministro de Hacienda, (iv) análisis y emisión de comentarios a los resultados intermedios, finales, (v) las recomendaciones, y por fin, (vi) información del cumplimiento de los compromisos institucionales. Los proyectos duran aproximadamente seis meses y el informe final de evaluación contiene los resultados de la evaluación, las conclusiones y recomendaciones que el panel propone para perfeccionar el desempeño de los programas.

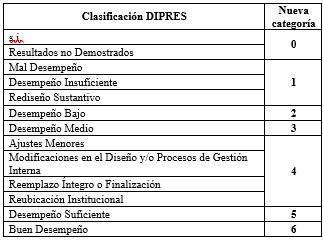

Esos resultados son expuestos a continuación. Las clasificaciones de los EPG presentados en el sitio de DIPRES fueron recategorizadas para fines de análisis, en seis grupos ordinales. Como se observa abajo y en orden creciente, se pusieron los “s.i.” y “resultados no demostrados” juntos; se agregaron “mal desempeño”, “desempeño insuficiente” y “rediseño sustantivo”; “desempeño bajo” y “desempeño medio” fueron mantenidos en categorías por separado; las clasificaciones de “ajustes menores”, “modificaciones en el diseño y/o procesos de gestión interna”, “reemplazo íntegro o finalización”, y “reubicación institucional” fueron insertas en un mismo grupo de recomendaciones; y finalmente, “desempeño suficiente” y “buen desempeño” cierran las nuevas categorías.

Tabla 2

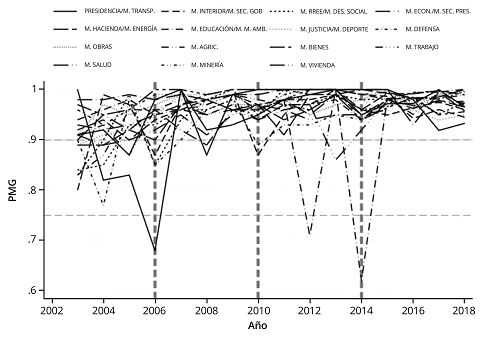

Para el gráfico de los boxplots también se incluyó abajo un gráfico de barras, pues los datos de EGP se muestran o con alta variación o con pocos casos en determinados años. Empezando el análisis por el gráfico de barras, hasta 2009, el promedio estuvo cerca de tres, lo que significa un desempeño medio de los programas evaluados. En ese intervalo y mirando el boxplot, las cajas se concentraron entre uno y cuatro. Después de 2010 y mirando los gráficos de barras, el promedio parece estar más cerca de dos, categoría de desempeño bajo. Las cajas todavía en ese período presentan mayor variación, concentrándose entre uno y cinco, lo que sugiere que, aunque el promedio en esa década estuvo más bajo, la variación fue equivalentemente alta.

Figura 5

Figura 6

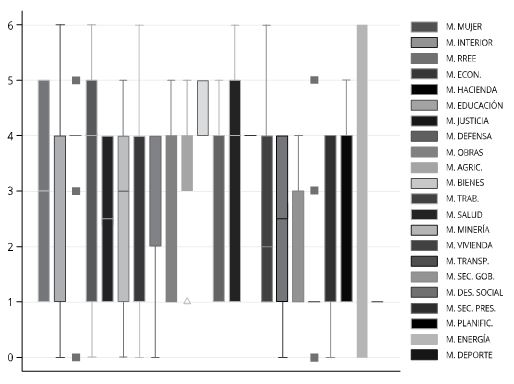

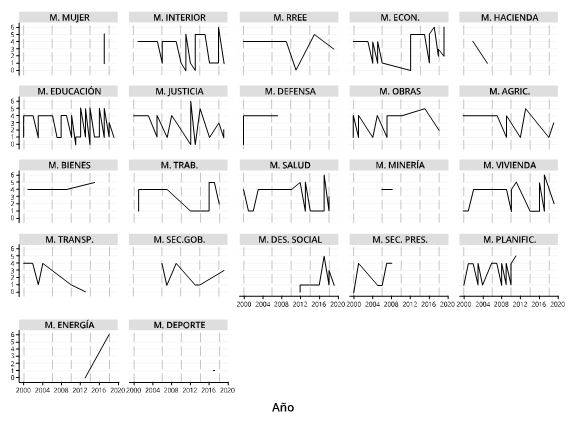

Por último, el comportamiento serial y desagregado de las instituciones similarmente presentan comportamiento difuso con alta variación, pero y tal como se indicó en los gráficos anteriores, con concentración oscilante en general entre valores uno y cuatro, en el tiempo. Así que no existe un periodo en particular que sugiera establecer algún cambio específico. Es decir, los años de los ciclos presidenciales electorales en las líneas de guion verticales, parecen no alterar los patrones difusos y oscilantes presentados por las burocracias en el caso del EPG.

De un lado, esa dinámica puede resultar de una variabilidad que viene desde las idiosincrasias de los procesos institucionales de selección de evaluadores y programas, hasta la flexibilidad de los criterios cualitativos de las evaluaciones que establece el EPG[9]. De otro, la variación también sugiere relativa heterogeneidad de los patrones de comportamiento de los resultados entre ministerios. En ese sentido, ninguna institución se ha destacado con malos o buenos desempeños sistemáticos. En los pocos momentos de más éxito presentados en el EPG, el Ministerio de Economía fue la única institución que ha alcanzado tres buenos desempeños en ese intervalo; el Ministerio del Interior (“M. INTERIOR”), de Justicia (“M. JUSTICIA”), de Salud (“M. SALUD”), de Vivienda (“M. VIVIENDA”), y de Energía (“M. ENERGÍA”), igual presentaron un único caso de buen desempeño en el periodo analizado.

Figura 7

Consideraciones finales

La investigación reitera la importancia, por un lado, de los resultados de estos dos instrumentos que forman parte y estructuran el sistema de evaluación de policies en el marco de la NGP en Chile en las últimas décadas. De otro, la evaluación de políticas públicas constituye una etapa fundamental de transparencia y accountability dentro el ciclo de políticas públicas. Así los patrones observados ofrecen contribuciones relevantes para analizar el comportamiento, monitoreo y evaluación de la gestión y de las políticas públicas chilenas en un intervalo de largo aliento.

Con relación a los resultados, los datos temporales del PMG se comportaron de manera concentrada y homogénea. Concentrada porque el promedio temporal del PMG estuvo por sobre el 95% de cumplimiento promedio de metas y gestión en los dieciséis años analizados. Homogéneo porque es bajísima la diferencia entre las instituciones analizadas que presentaron solamente un promedio de un 1,8% de variación entre ellas, comparativamente.

Cabe señalar que el cumplimento del PMG por sobre el 90% garantiza el pago completo de la bonificación disponible, mientras que, si el nivel de cumplimiento está en el tramo del 90% y 75% el beneficio disminuye, y por debajo del 75% se pierde el incentivo o bono por desempeño. Ese resultado concentrado y homogéneo o sugiere que el planeamiento y/o cumplimiento de tareas tiene como planes y metas, objetivos demasiado bajos, o que el Estado y sus miembros ejecutan los objetivos planteados por la administración sistemática y completamente. En ese sentido y considerando la realidad y complejidad de la gestión de políticas públicas, se sugiere que en esos escenarios de subvaloración de las metas o de sobrevalorización del cumplimiento, por parte de los actores políticos y/o burocráticos, ambos apuntan para la dirección de manipulación, también llamada de práctica de gaming, de ese indicador (Zaviezo …[et al], 2016). Ese aspecto muestra un efecto perverso tanto al aumentar costos tangibles e intangibles a los recursos, gestión e innovación del Estado (idem) como presenta, al final, un bajo poder informativo -homogeneizando las diferencias intraburocráticas y entre las instituciones. Por lo tanto, la incorporación del PMG como parte del sueldo, vulgo una especie de aguinaldo, distorsiona sus propósitos originales de un mecanismo de incentivo y motivación institucional al alcance de metas gubernamentales, constituyéndose en un informe con el puro objetivo de alcanzar el 100% de las bonificaciones -mirando y jugando sistemáticamente las metas institucionales del PMG por sobre el 90%. Así se han observado pocos casos bajo el 90% y solamente tres en el tramo inferior a un 75% en los dieciséis años analizados.

Con el EPG se propuso agregar algunas de las clasificaciones de la DIPRES, en nuevas categorías, para analizar ese indicador más apropiadamente. Aunque la naturaleza de esa evaluación sea distinta a la del PMG, el EPG gana cualitativa e informativamente. Así que, de un lado, el EPG ha presentado resultados más difusos y heterogéneos -sin un patrón intraburocrático ni entre las instituciones, en el tiempo, en una mirada descriptiva. De otro y aunque las idiosincrasias institucionales sumadas a los criterios de selección de programas y de evaluadores -que se utilizan de metodologías cualitativas- colaboren para una mayor variación de sus resultados, se verifica que los indicadores EPG oscilaron mucho entre uno y cuatro, es decir, entre mal, bajo y medio desempeño, y también con sugerencias de cambios. Los resultados para la EPG, en síntesis y en su promedio en el tiempo, señalan que los programas y políticas públicas en Chile tienen calidad baja y media, inestable entre esos parámetros. En sentido distinto al PMG, se han observado pocos casos de buen desempeño en las dos décadas de evaluaciones de los EPG.

Por último y aunque el PMG y EPG estén insertos en el ciclo presupuestario, se refuerzan las críticas de la OCDE de que ellos no tienen una relación formal y directa entre sus resultados y los gastos públicos nacionales (OCDE Survey on Policy Evaluation 2018 Apud DIPRES, 2019b: 121). Súmanse a eso la baja relación entre evaluaciones ex ante y ex post, aspecto que vuelve aún más débil el sistema de evaluación en Chile, que no se conectan efectivamente entre sí y tampoco influyen en la elección y direccionamiento de los recursos de manera clara.

Se reitera en ese sentido que sin una estructura efectiva ni checks institucionales, la evaluación pierde capacidad de impactar de hecho en la cantidad y calidad de las políticas públicas producidas. La etapa de evaluación tiene alta importancia, pues su no existencia o bajo rol en el ciclo de políticas públicas incide no solamente en una menor transparencia de los resultados, sino que también en pérdida de retroalimentaciones de aprendizajes organizacionales (Hill y Hupe 2002). Ante la potencial ausencia de feedback loops positivos (idem) se hace inevitable las consecuencias en las etapas de formulación e implementación. Una evaluación inexistente o con funcionamiento inapropiado, aumenta los incentivos para que esas etapas anteriores se vuelvan aún más cerradas y endógenas, disminuyendo la transparencia, y botando a la basura potenciales mejorías procedimentales en dichos procesos -así se pierden oportunidades de mayor éxito en nuevas rondas de desarrollo y retroalimentaciones en el ciclo de policies. La evaluación por lo tanto impacta cuantitativa y cualitativamente en las políticas públicas producidas, siendo una herramienta que mide su calidad y eficiencia (Wu …[et al], 2018).

Tabla 3

La Tabla 3 sintetiza y concluye los hallazgos de esos dos instrumentos institucionales de programas y políticas públicas del servicio civil chileno, en dieciséis y veinte años de datos analizados.